NYT vs Open AI: Sfide Etiche e Legali nell’AI Generativa

La disputa NYT vs OpenAI solleva questioni etiche e legali nell’AI generativa: la battaglia legale si focalizza sulle violazioni di copyright e plagio, sottolineata dalla capacità dei modelli come GPT-4 di replicare testi protetti, il dibattito tecnico indaga l’influenza dei dati di addestramento sui modelli di AI. A livello morale, emerge il conflitto tra progresso tecnologico e diritti dei lavoratori-creatori.

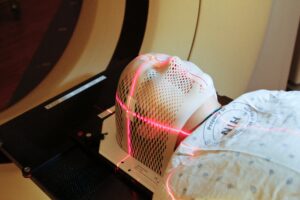

L’AI in Oncologia: per un’assistenza sanitaria più umana

L’articolo affronta le innovazioni e le sfide etiche poste dall’impiego delle tecnologie di intelligenza artificiale (AI) nella medicina, con un focus particolare sui pazienti oncologici.

Litio in Argentina: tra diritti violati e impatto ambientale

L’articolo evidenzia le repressioni violente delle proteste scaturite in seguito a modifiche significative della costituzione argentina, mirate a favorire l’estrazione del litio, una risorsa sempre più richiesta globalmente per la produzione di batterie per auto elettriche, computer e telefoni cellulari.

Diplomazia Segreta Cino-Statunitense per la Sicurezza dell’AI

Madhumita Murgia, nel Financial Times di giovedì 11 gennaio 2024, ha rivelato l’esistenza di incontri segreti focalizzati sulla sicurezza dell’intelligenza artificiale (AI), tenutisi a Ginevra in due distinti momenti, uno a luglio e l’altro a ottobre dell’anno precedente. Questi dialoghi di alto livello hanno coinvolto scienziati e esperti politici di spicco provenienti da eminenti gruppi nordamericani nel campo dell’AI, quali OpenAI, Anthropic e Cohere, che si sono seduti al tavolo delle trattative con rappresentanti dell’Università di Tsinghua e di altre rinomate istituzioni statali cinesi.

New York Times vs OpenAI e Microsoft: si può applicare la norma del “fair use”?

La disputa legale tra il New York Times, da un lato, e OpenAI e Microsoft, dall’altro, ruota attorno all’accusa di violazione del copyright del New York Times. La querela sostiene che le due aziende tecnologiche abbiano illegalmente utilizzato “milioni” di articoli protetti dal copyright del Times per sviluppare i modelli di intelligenza artificiale di strumenti come ChatGPT e Bing. Questo caso, l’ultimo di una serie di cause attive, potrebbe influenzare significativamente l’industria dell’IA generativa.

I Robot Artisti

Agnieszka Pilat, artista che risiede presso SpaceX a Hawthorne, California, ha curato un’eccezionale mostra in collaborazione con i robot cani Spot di Boston Dynamics presso la National Gallery of Victoria a Melbourne, Australia. Pilat, originaria della Polonia e cresciuta dietro la “Cortina di Ferro”, vede la tecnologia come una “speranza”.

Il modello cinese di AI

La Cina ha fissato l’ambizioso obiettivo di diventare leader mondiale nell’IA entro il 2030. Tuttavia, l’emergere di tecnologie come ChatGPT, sviluppate negli Stati Uniti, ha messo in discussione questa aspirazione, evidenziando le divergenze nei modelli di AI tra le due potenze.

L’AI in medicina: responsabilità condivisa e approccio “learn not blame”

Nell’articolo “Artificial intelligence in clinical decision-making: Rethinking personal moral responsibility”, pubblicato su “Bioethics” del 19 settembre 2023, Helen Smith, Giles Birchley e Jonathan Ives affrontano il ruolo dell’intelligenza artificiale (AI) in medicina e la ridefinizione della responsabilità.

Interfaccia cervello-computer: questioni etico-legali

L’immaginario di un futuro in cui i pensieri umani sono verbalizzati attraverso una sorta di interfaccia esterna porta con sé interrogativi sulla privacy individuale e sulla libertà di scelta. Questa prospettiva inquietante suscita un’attenta riflessione sulle normative e sulle linee guida necessarie per regolamentare queste tecnologie che possono avere un utilizzo benefico. Va sottolineato infatti il potenziale positivo di queste tecnologie, in particolare nel supporto a individui affetti da gravi patologie neurologiche, come la sindrome di Locked-in, per migliorare la loro comunicazione e interazione con il mondo esterno.

Allineare l’Intelligenza Artificiale con i Valori Umani

Il post pubblicato il 27 dicembre su LessWrong, un sito e una comunità online dedicati al pensiero razionalista, solleva l’importante questione di come allineare i sistemi di Intelligenza Artificiale (AI) con i valori umani. L’articolo esplora la sfida di garantire che il futuro dell’AI rifletta ciò che gli esseri umani considerano prezioso, desiderabile e moralmente accettabile.