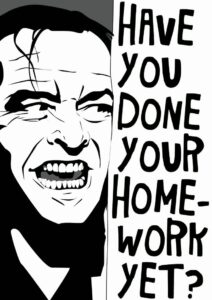

Zitta zitta Open AI, come si legge sul loro sito, ha dismesso il classificatore per verificare se un testo sia stato prodotto dall’AI o da esseri umani. Il tool era era stato presentato con grande fanfara il 31 gennaio 2023 in risposta alle forti polemiche riguardo all’uso di ChatGPT per produrre testi attribuibili a persone, in particolare nel mondo dell’istruzione, dato che ChatGPT dà la possibilità di “copiare” i compiti senza possibilità per l’insegnante di accorgersene:

As of July 20, 2023, the AI classifier is no longer available due to its low rate of accuracy. We are working to incorporate feedback and are currently researching more effective provenance techniques for text, and have made a commitment to develop and deploy mechanisms that enable users to understand if audio or visual content is AI-generated.

Il tool per altro non aveva mai funzionato in maniera soddisfacente, come ammetteva OpenAI nello stesso post:

Our classifier is not fully reliable. In our evaluations on a “challenge set” of English texts, our classifier correctly identifies 26% of AI-written text (true positives) as “likely AI-written,” while incorrectly labeling human-written text as AI-written 9% of the time (false positives). Our classifier’s reliability typically improves as the length of the input text increases. Compared to our previously released classifier, this new classifier is significantly more reliable on text from more recent AI systems.

Ma era chiaro che si trattava fin dall’inizio solo di una operazione retorica per distrarre dal problema dell’esplosione del plagiarismo abilitato dall’AI.