Per una Intelligenza Artificiale inclusiva

L’articolo di Kave Noori, su European Disability Forum Report del 28 agosto 2023, esplora il potenziale dell’Intelligenza Artificiale (IA) nel migliorare la vita delle persone con disabilità. L’IA può fornire soluzioni personalizzate che migliorano la qualità della vita, ma c’è anche il rischio che, se non viene adeguatamente addestrata, diventi strumento di discriminazione. L’articolo enfatizza la necessità di un […]

Proteggere i neurodati e regolamentare le neurotecnologie basate sull’intelligenza artificiale

Introduzione L’articolo A difesa della privacy dei neurodati e della regolamentazione delle neurotecnologie, scritto da Rafael Yuste e pubblicato su Nature Protocols l’11 settembre 2023, sottolinea la necessità di affrontare con consapevolezza le complesse questioni etiche sollevate dalle neurotecnologie per garantirne una crescita responsabile. Propone soluzioni tecniche, regolamentazioni mediche e l’adozione di un Giuramento Tecnocratico come […]

Più di 110 docenti universitari da tutta Europa e oltre chiedono alle istituzioni europee di includere una valutazione dell’impatto sui diritti fondamentali nella futura regolamentazione sull’intelligenza artificiale

Il 12 settembre 2023, il Brussels Privacy Hub ha lanciato un appello per approvare una valutazione dell’impatto sui diritti fondamentali nei documenti sull’intelligenza artificiale (AI) dell’Unione Europea (UE). Questo appello è stato sottoscritto da oltre 110 firmatari, tra cui illustri accademici (l’Italia ha il maggior numero di firmatari, 14). Il Brussels Privacy Hub, insieme a […]

I bias non sono (solo) spazzatura: Biased Data as Informative Artifacts in AI-Assisted Health Care

Un recente articolo scientifico tratta dell’uso di strumenti di intelligenza artificiale nel campo della medicina, in particolare sulla presenza di bias nei dati clinici utilizzati per addestrare tali strumenti. Nell’approccio tradizionale, i dati clinici “biased” sono spesso considerati come dati di bassa qualità, in linea con il detto informatico “garbage in, garbage out“. Questo suggerisce […]

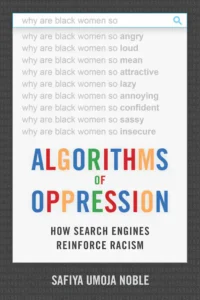

Algorithms of Oppression

How Search Engines Reinforce Racism di Safiya Umoja Noble Uno sguardo su come i pregiudizi negativi nei confronti delle donne nere siano incorporati negli algoritmi dei motori di ricerca. In Algorithms of Oppression, Safiya Umoja Noble sostiene che la combinazione di interessi privati nella promozione di alcuni siti, insieme allo status di monopolio di un […]

Gli algoritmi discriminatori della Banca Mondiale| Human Rights Watch

I governi di tutto il mondo si stanno rivolgendo all’automazione per aiutarli a fornire servizi pubblici essenziali, ma alcune forme di automazione escludono le persone dai servizi e le sottopongono a controlli basati su errori, criteri discriminatori o stereotipi sulla povertà. La Banca Mondiale è uno dei principali attori dello sviluppo che guida questa tendenza, […]