L’AI intervista i pazienti

L’oggetto della ricerca è un sistema di AI, basato su un modello avanzato di linguaggio (LLM), progettato per condurre interviste mediche. Questo chatbot AI, denominato Articulate Medical Intelligence Explorer (AMIE), è stato sviluppato per interagire con pazienti simulati, raccogliere la loro storia medica e fornire possibili diagnosi.

Il sistema è stato addestrato utilizzando dialoghi sia reali sia simulati, con lo scopo di imitare le interazioni tra medico e paziente. Per testare l’efficacia di AMIE, sono stati organizzati incontri online, basati su interazioni testuali, con attori formati per impersonare pazienti affetti da varie condizioni mediche. Questi incontri sono stati confrontati con quelli condotti da medici umani, valutando l’accuratezza delle diagnosi e la qualità della conversazione.

L’AI per la segnalazione della pedopornografia

Questa analisi mette in evidenza una complessa interazione tra innovazioni tecnologiche, normative legali e l’imperativo etico della protezione dei minori. La dipendenza crescente dall’AI e le restrizioni legali presenti creano ostacoli significativi in una risposta efficace e tempestiva alle segnalazioni di abuso sessuale su minori online.

NYT vs Open AI: Sfide Etiche e Legali nell’AI Generativa

La disputa NYT vs OpenAI solleva questioni etiche e legali nell’AI generativa: la battaglia legale si focalizza sulle violazioni di copyright e plagio, sottolineata dalla capacità dei modelli come GPT-4 di replicare testi protetti, il dibattito tecnico indaga l’influenza dei dati di addestramento sui modelli di AI. A livello morale, emerge il conflitto tra progresso tecnologico e diritti dei lavoratori-creatori.

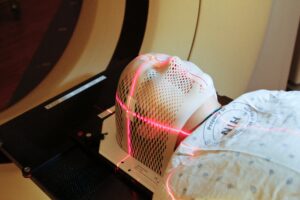

L’AI in Oncologia: per un’assistenza sanitaria più umana

L’articolo affronta le innovazioni e le sfide etiche poste dall’impiego delle tecnologie di intelligenza artificiale (AI) nella medicina, con un focus particolare sui pazienti oncologici.

Il modello cinese di AI

La Cina ha fissato l’ambizioso obiettivo di diventare leader mondiale nell’IA entro il 2030. Tuttavia, l’emergere di tecnologie come ChatGPT, sviluppate negli Stati Uniti, ha messo in discussione questa aspirazione, evidenziando le divergenze nei modelli di AI tra le due potenze.

L’AI in medicina: responsabilità condivisa e approccio “learn not blame”

Nell’articolo “Artificial intelligence in clinical decision-making: Rethinking personal moral responsibility”, pubblicato su “Bioethics” del 19 settembre 2023, Helen Smith, Giles Birchley e Jonathan Ives affrontano il ruolo dell’intelligenza artificiale (AI) in medicina e la ridefinizione della responsabilità.

Interfaccia cervello-computer: questioni etico-legali

L’immaginario di un futuro in cui i pensieri umani sono verbalizzati attraverso una sorta di interfaccia esterna porta con sé interrogativi sulla privacy individuale e sulla libertà di scelta. Questa prospettiva inquietante suscita un’attenta riflessione sulle normative e sulle linee guida necessarie per regolamentare queste tecnologie che possono avere un utilizzo benefico. Va sottolineato infatti il potenziale positivo di queste tecnologie, in particolare nel supporto a individui affetti da gravi patologie neurologiche, come la sindrome di Locked-in, per migliorare la loro comunicazione e interazione con il mondo esterno.

Allineare l’Intelligenza Artificiale con i Valori Umani

Il post pubblicato il 27 dicembre su LessWrong, un sito e una comunità online dedicati al pensiero razionalista, solleva l’importante questione di come allineare i sistemi di Intelligenza Artificiale (AI) con i valori umani. L’articolo esplora la sfida di garantire che il futuro dell’AI rifletta ciò che gli esseri umani considerano prezioso, desiderabile e moralmente accettabile.

Report 2023 sull’AI a scopo repressivo

Il rapporto Freedom on the Net 2023 di Freedom House esamina l’uso crescente dell’intelligenza artificiale (AI) per scopi repressivi in tutto il mondo. Il report rileva che l’AI viene utilizzata per sorvegliare, censurare e controllare i cittadini in molti paesi.

La querela del New York Times contro OpenAI e Microsoft

La querela mette in luce come l’uso non autorizzato dei contenuti giornalistici nell’addestramento delle intelligenze artificiali possa compromettere le entrate delle organizzazioni giornalistiche, minare la loro integrità editoriale e indebolire la fiducia del pubblico nelle fonti tradizionali di informazione.